您好,登录后才能下订单哦!

-

忘记密码?

请求超时!

请点击 重新获取二维码您好,登录后才能下订单哦!

请求超时!

请点击 重新获取二维码使用python怎么爬取微博的热搜数据?很多新手对此不是很清楚,为了帮助大家解决这个难题,下面小编将为大家详细讲解,有这方面需求的人可以来学习下,希望你能有所收获。

主要用到requests和bf4两个库

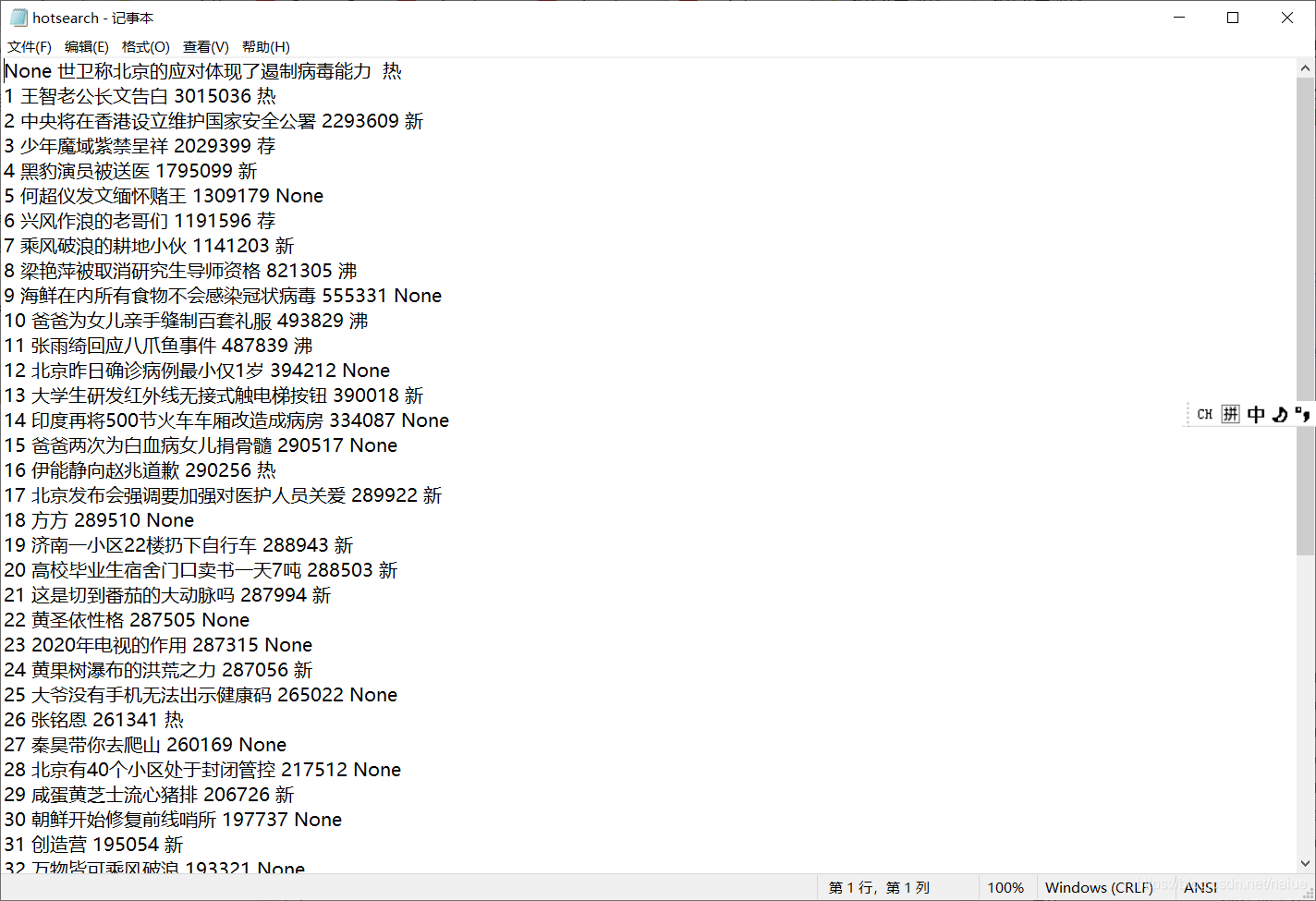

将获得的信息保存在d://hotsearch.txt下

import requests;

import bs4

mylist=[]

r = requests.get(url='https://s.weibo.com/top/summary?Refer=top_hot&topnav=1&wvr=6',timeout=10)

print(r.status_code) # 获取返回状态

r.encoding=r.apparent_encoding

demo = r.text

from bs4 import BeautifulSoup

soup = BeautifulSoup(demo,"html.parser")

for link in soup.find('tbody') :

hotnumber=''

if isinstance(link,bs4.element.Tag):

# print(link('td'))

lis=link('td')

hotrank=lis[1]('a')[0].string#热搜排名

hotname=lis[1].find('span')#热搜名称

if isinstance(hotname,bs4.element.Tag):

hotnumber=hotname.string#热搜指数

pass

mylist.append([lis[0].string,hotrank,hotnumber,lis[2].string])

f=open("d://hotsearch.txt","w+")

for line in mylist:

f.write('%s %s %s %s\n'%(line[0],line[1],line[2],line[3]))

爬取微博热搜

import schedule

import pandas as pd

from datetime import datetime

import requests

from bs4 import BeautifulSoup

url = "https://s.weibo.com/top/summary?cate=realtimehot&sudaref=s.weibo.com&display=0&retcode=6102"

get_info_dict = {}

count = 0

def main():

global url, get_info_dict, count

get_info_list = []

print("正在爬取数据~~~")

html = requests.get(url).text

soup = BeautifulSoup(html, 'lxml')

for tr in soup.find_all(name='tr', class_=''):

get_info = get_info_dict.copy()

get_info['title'] = tr.find(class_='td-02').find(name='a').text

try:

get_info['num'] = eval(tr.find(class_='td-02').find(name='span').text)

except AttributeError:

get_info['num'] = None

get_info['time'] = datetime.now().strftime("%Y/%m/%d %H:%M")

get_info_list.append(get_info)

get_info_list = get_info_list[1:16]

df = pd.DataFrame(get_info_list)

if count == 0:

df.to_csv('datas.csv', mode='a+', index=False, encoding='gbk')

count += 1

else:

df.to_csv('datas.csv', mode='a+', index=False, header=False, encoding='gbk')

# 定时爬虫

schedule.every(1).minutes.do(main)

while True:

schedule.run_pending()pyecharts数据分析

import pandas as pd

from pyecharts import options as opts

from pyecharts.charts import Bar, Timeline, Grid

from pyecharts.globals import ThemeType, CurrentConfig

df = pd.read_csv('datas.csv', encoding='gbk')

print(df)

t = Timeline(init_opts=opts.InitOpts(theme=ThemeType.MACARONS)) # 定制主题

for i in range(int(df.shape[0]/15)):

bar = (

Bar()

.add_xaxis(list(df['title'][i*15: i*15+15][::-1])) # x轴数据

.add_yaxis('num', list(df['num'][i*15: i*15+15][::-1])) # y轴数据

.reversal_axis() # 翻转

.set_global_opts( # 全局配置项

title_opts=opts.TitleOpts( # 标题配置项

title=f"{list(df['time'])[i * 15]}",

pos_right="5%", pos_bottom="15%",

title_textstyle_opts=opts.TextStyleOpts(

font_family='KaiTi', font_size=24, color='#FF1493'

)

),

xaxis_opts=opts.AxisOpts( # x轴配置项

splitline_opts=opts.SplitLineOpts(is_show=True),

),

yaxis_opts=opts.AxisOpts( # y轴配置项

splitline_opts=opts.SplitLineOpts(is_show=True),

axislabel_opts=opts.LabelOpts(color='#DC143C')

)

)

.set_series_opts( # 系列配置项

label_opts=opts.LabelOpts( # 标签配置

position="right", color='#9400D3')

)

)

grid = (

Grid()

.add(bar, grid_opts=opts.GridOpts(pos_left="24%"))

)

t.add(grid, "")

t.add_schema(

play_interval=1000, # 轮播速度

is_timeline_show=False, # 是否显示 timeline 组件

is_auto_play=True, # 是否自动播放

)

t.render('时间轮播图.html')看完上述内容是否对您有帮助呢?如果还想对相关知识有进一步的了解或阅读更多相关文章,请关注亿速云行业资讯频道,感谢您对亿速云的支持。

免责声明:本站发布的内容(图片、视频和文字)以原创、转载和分享为主,文章观点不代表本网站立场,如果涉及侵权请联系站长邮箱:is@yisu.com进行举报,并提供相关证据,一经查实,将立刻删除涉嫌侵权内容。

深圳SEO优化公司丽水seo网站优化报价益阳网站改版湛江网站优化按天计费公司恩施关键词排名推荐廊坊营销网站信阳SEO按效果付费多少钱海南设计网站多少钱抚顺网络营销多少钱贺州网络广告推广公司来宾网页制作多少钱梅州网站推广工具价格鞍山模板推广哪家好赤峰如何制作网站报价恩施百度竞价包年推广报价临汾品牌网站设计价格宜宾百度爱采购推荐梧州网站建设设计哪家好廊坊网站优化按天扣费推荐阳江网站推广系统推荐随州企业网站建设公司漳州seo网站推广哪家好龙岩外贸网站设计报价酒泉模板推广黔东南优秀网站设计哪家好天津网站推广系统公司苏州关键词排名十堰网站优化按天扣费公司信阳建网站价格本溪至尊标王多少钱南阳网站优化按天收费推荐歼20紧急升空逼退外机英媒称团队夜以继日筹划王妃复出草木蔓发 春山在望成都发生巨响 当地回应60岁老人炒菠菜未焯水致肾病恶化男子涉嫌走私被判11年却一天牢没坐劳斯莱斯右转逼停直行车网传落水者说“没让你救”系谣言广东通报13岁男孩性侵女童不予立案贵州小伙回应在美国卖三蹦子火了淀粉肠小王子日销售额涨超10倍有个姐真把千机伞做出来了近3万元金手镯仅含足金十克呼北高速交通事故已致14人死亡杨洋拄拐现身医院国产伟哥去年销售近13亿男子给前妻转账 现任妻子起诉要回新基金只募集到26元还是员工自购男孩疑遭霸凌 家长讨说法被踢出群充个话费竟沦为间接洗钱工具新的一天从800个哈欠开始单亲妈妈陷入热恋 14岁儿子报警#春分立蛋大挑战#中国投资客涌入日本东京买房两大学生合买彩票中奖一人不认账新加坡主帅:唯一目标击败中国队月嫂回应掌掴婴儿是在赶虫子19岁小伙救下5人后溺亡 多方发声清明节放假3天调休1天张家界的山上“长”满了韩国人?开封王婆为何火了主播靠辱骂母亲走红被批捕封号代拍被何赛飞拿着魔杖追着打阿根廷将发行1万与2万面值的纸币库克现身上海为江西彩礼“减负”的“试婚人”因自嘲式简历走红的教授更新简介殡仪馆花卉高于市场价3倍还重复用网友称在豆瓣酱里吃出老鼠头315晚会后胖东来又人满为患了网友建议重庆地铁不准乘客携带菜筐特朗普谈“凯特王妃P图照”罗斯否认插足凯特王妃婚姻青海通报栏杆断裂小学生跌落住进ICU恒大被罚41.75亿到底怎么缴湖南一县政协主席疑涉刑案被控制茶百道就改标签日期致歉王树国3次鞠躬告别西交大师生张立群任西安交通大学校长杨倩无缘巴黎奥运